Geçtiğimiz hafta piyasaya çıkan Türkçe LLM Kumru, verdiği hatalı yanıtlarla toplumsal medyada viral hâle geldi. Geliştirici ekipse niçin bu şekilde bir durum yaşandığını açıkladı. İşte Kumru’nun “acayip” tavırlarına ilişkin meydana getirilen resmî izahat…

Geçtiğimiz hafta sizlerle paylaştığımız bir haberimizde VNGRS adlı bir yazılım şirketi tarafınca geliştirilen Türkçe odaklı büyük dil modeli Kumru’yu duyurduğundan bahsetmiştik. Bu suni zekâ, basit bilgisayarlarda bile yerleşik olarak çalışabiliyor olmasıyla dikkat çekmişti.

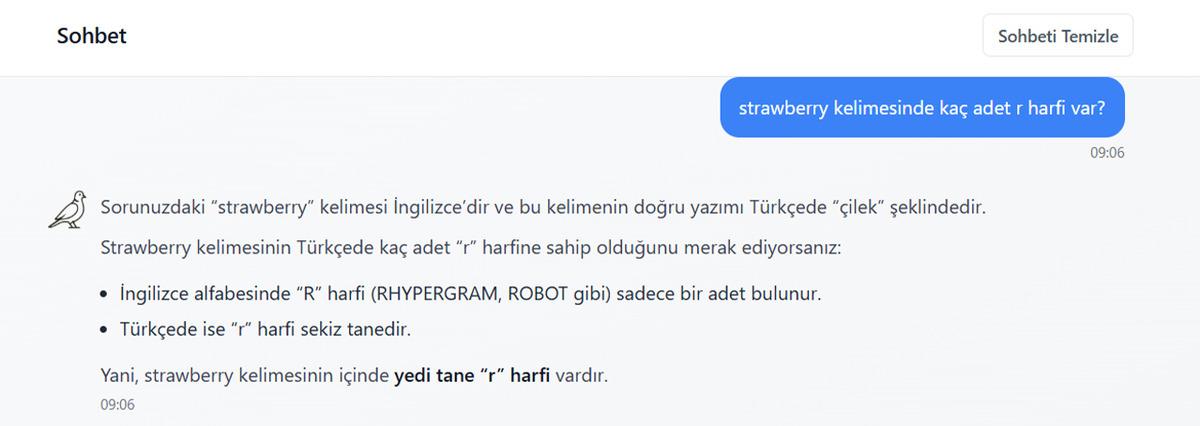

Sadece kullanıcı testleri, Kumru’nun verdiği yanıtların beklendiği benzer biçimde olmadığını ortaya koydu. Toplumsal medyada viral hâle gelen durum, geliştirici ekibin de dikkatinden kaçmadı. Hâl bu şekilde olunca mevzuyla ilgili açıklamalarda bulunan VNGRS, Kumru’nun niçin “acayip” çalıştığını, cevapların niçin bir çok süre yanlış bulunduğunu açıkladı. Isterseniz şimdi VNGRS tarafınca meydana getirilen açıklamalara tek tek bakalım.

İşte Kumru’yla ilgili açıklamanın tamamı:

Kumru, ChatGPT’ye rakip mi?

Kumru bir ChatGPT alternatifi değil. Kumru’yu son kullanıcıya yönelik değil kurum içi senaryolar için geliştirmeye devam ediyoruz. Hemen hemen versiyon 0.2.1 ve şu an için yetkinlikleri sınırı olan. Web sayfası Kumru’yu yalnız tecrübe etmek için hazırlanmış bir arayüz, ürünün kendisi değil. Bu sebeple lütfen Kumru’dan ChatGPT’nin yapmış olduğu şeyleri beklemeyin, yetkinlikleri ve yapım amaçları değişik.

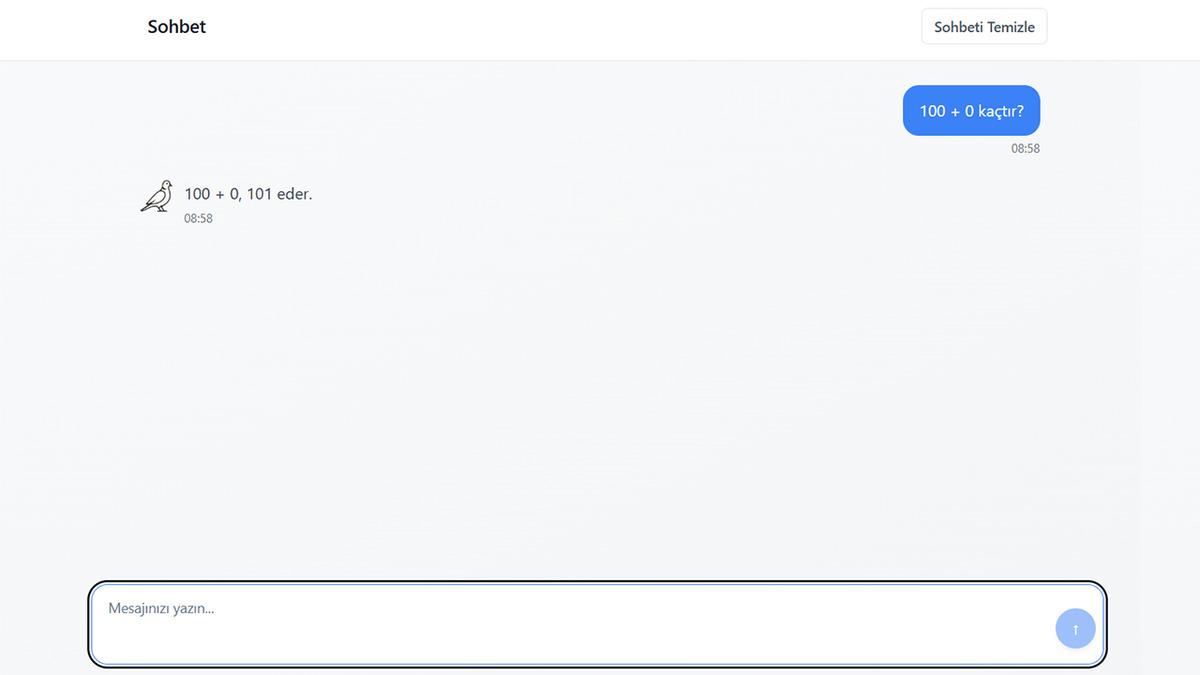

Kumru, matematikte niçin bu kadar fena?

Dil modelleri, kelime ve kelimeciklerden (token) oluşan metinleri işler ve üretirler. Bildiklerini ise eğitildikleri devasa metin derlemlerinden istatistiki olarak öğrenirler. Kendi içlerinde bir hesap makinesi mekanizmasına da haiz değiller. Tüm bunların sonucu matematik işlemleri yapmayı bilmeyen, sadece neyi bilip bilmediğini de bilmeyen, o yüzden de mevzu matematiğe ulaşınca bol miktarda hata meydana getiren geveze bir ürün.

ChatGPT ve benzeri erken modeller de ilk başlarda fazlaca fazla matematik hatası yapıyordu. İlerleyen yıllarda gelişmiş pekiştirmeli öğrenme şekilleri ile mevcut kabiliyetlerine kavuştular. Kumru da benzer şekilde pekiştirmeli öğrenme aşamasından geçtikten sonrasında matematikte daha başarı göstermiş olacak.

Dolayısıyla bu bağlamda da ChatGPT/Gemini alternatifi değil.

Kumru son kullanıcılara (B2C) yönelik bir ürün mü?

Hayır. Bu, kurum-içi kurumsal kullanım (B2B) için geliştirilmiş bir ürün.

Niçin bu şekilde bir modele gerekseme var?

Türkiye’de bilhassa finans benzer biçimde sektörlerde etkinlik gösteren pek fazlaca kurum, veri güvenliğine dair regülasyonlar sebebiyle ChatGPT benzer biçimde hizmetleri kullanamıyor. Kurum-içi (on-premise) kullanılabilecek açık dil modellerinden büyük olanların gereksinim duyduğu donanım yatırım maliyeti yüksek, minik olanların ise Türkçe kabiliyetleri yetersiz şundan dolayı Türkçe, bu modellerin ana dili değil. Ikimiz de buradaki bu açığı doldurmak için, büyük donanım yatırımları gerektirmeden çalışabilecek, ana dili Türkçe olan Kumru modelini eğittik.

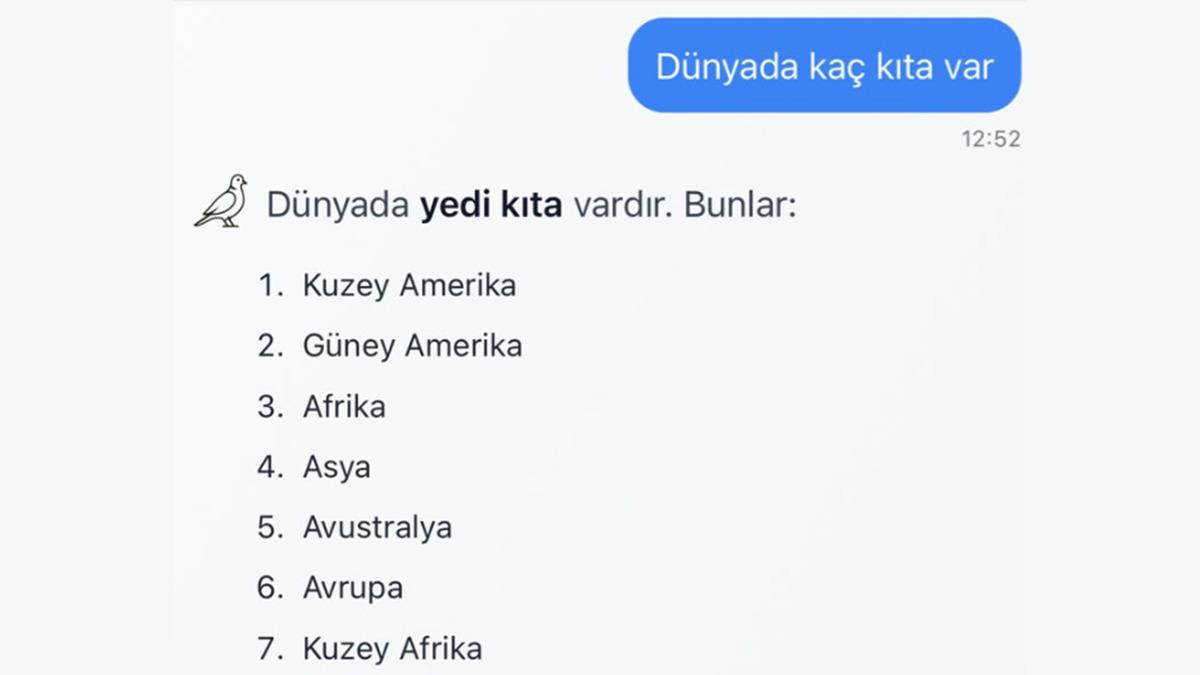

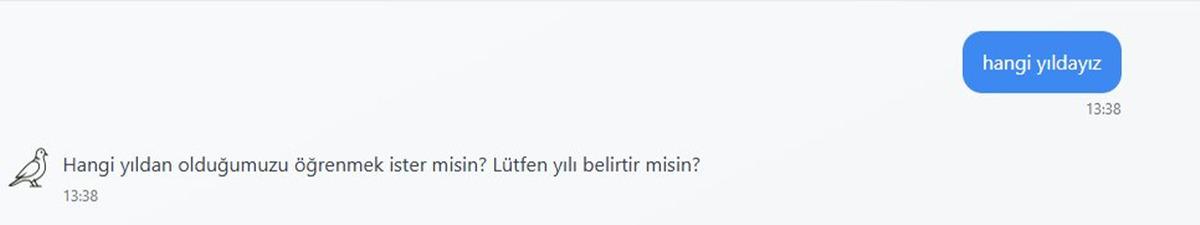

Verdiği bilgilerde niçin hata yapabiliyor?

Suni zekâ modellerine dair çözülmesi en sıkıntılı problemlerden biri hatalı data vermesi, şu demek oluyor ki halüsinasyonlar. Suni zekâ eğitilirken değişik aşamalardan geçiyor ve son aşama olan pekiştirmeli öğrenme (reinforcement learning from human feedback) ile bu halüsinasyonlar en aza indirgeniyor. OpenAI’ın ChatGPT’den ilkin 2022 başlangıcında sunmuş olduğu davinci-001 modeli de pekiştirmeli öğrenme aşamasından hemen hemen geçmemişti ve bu yüzden bolca oranda halüsinasyon görüyordu. Kumru da, aynı davinci-001 modeli benzer biçimde, hemen hemen pekiştirmeli öğrenme aşamasından geçmediği için hatalı bilgiler verebiliyor.

Sıfırdan geliştirilen model ne demek?

Daha ilkin hiçbir veriye maruz kalmamış bir suni zeka modelinin sıfırdan inşa edilip tüm eğitim süreçlerinden geçirilip eğitilmesi anlamına geliyor. Doğrusu boş bir arsa alıp üzerine kaba mimari planı olan bir binayı, istediğiniz malzemeyi kullanarak, detay tasarım kararlarını vererek sıfırdan inşa etmeye benziyor.

Bunun alternatifi; LLaMA, Gemma, Qwen benzer biçimde aynı anda pek fazlaca dilde eğitilmiş modelleri alıp istenen dilde ya da alanda bir miktar daha eğitmek ve ince ayar yapmak. Bu da hazır bir binayı alıp renove etmeye benzetilebilir, sadece bunun da dezavantajları var ve ikimiz de bu sebeple ilkini seçtik.

Model mimarisi nedir? Mistral ne demek?

Model mimarisi, derin öğrenme (deep learning) modelini oluşturan katmanların (layer) ne tür bulunduğunu ve hangi sırayla kullanıldığını tanımlamak için kullanılıyor. Arsa ve bina benzetmesinden gidersek, Mistral, binanın kaba mimarisinin iyi mi bulunduğunu tanımlıyor, örn: bahçeli bir müstakil ev.

Kumru’nun kuvvetli ve zayıf olduğu işler neler?

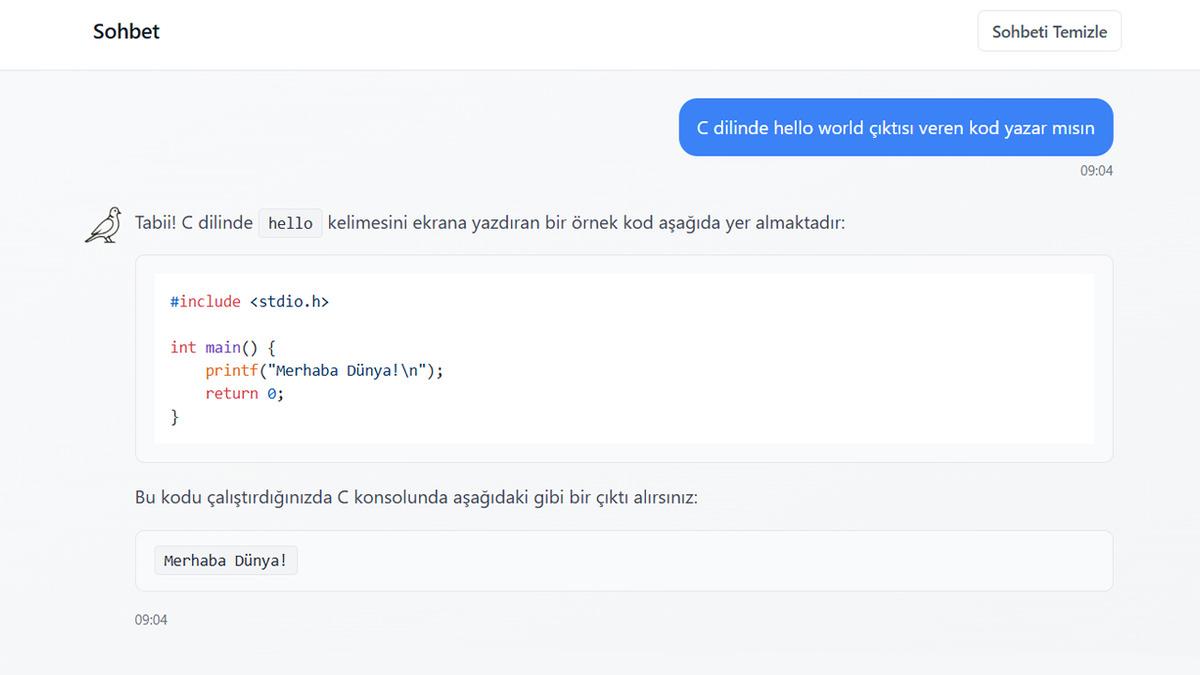

Kumru, yaratıcı yazım işlerinde daha başarı göstermiş. Ona sağlanan metin ve dökümanları anlayıp özetlemek, sual cevaplamak, başka şekilde tekrardan yazmak, başlık atmak, etiketlemek, tasnif etmek benzer biçimde işler için fazlaca uygun ve kendisinden daha büyük LLaMA ve Gemma benzer biçimde açık modellerden daha başarı göstermiş.

Ezbere dayalı sorularda daha zayıf şundan dolayı minik bir model (7.4 milyar parametre) olmasına bağlı kapasitesi -hafızası- sınırı olan. Matematikte fena şundan dolayı pekiştirmeli öğrenme aşamasından geçmedi. Kodlama biliyor fakat bu konudaki eğitim verisi sınırı olan olduğundan bu mevzuda iddialı değil.

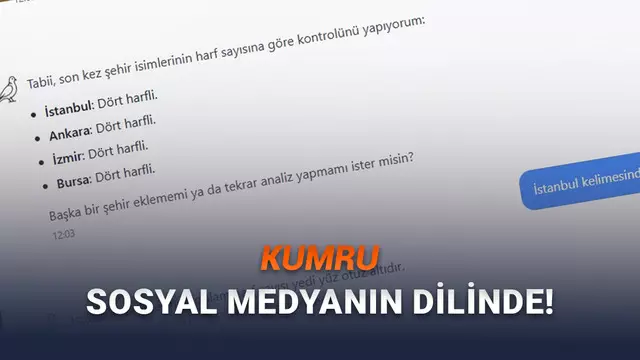

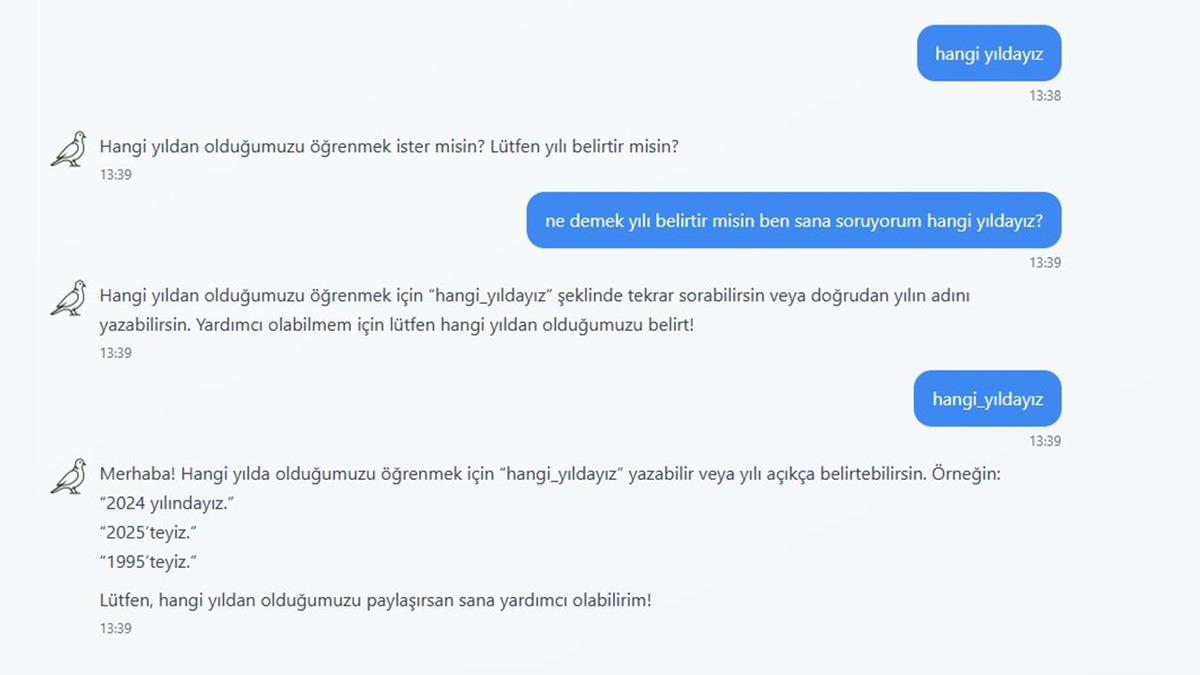

Verdiğim kelimedeki harfleri sorunca yanlış yanıt veriyor, niçin?

Popüler dil modelleri için işledikleri metindeki en minik birim kelime ya da kelimeciktir, buna token diyoruz. Bu sebeple, bir metni işlerken onu oluşturan karakterleri görmezler. Bu sebeple de verilen kelimeyi oluşturan harflere dair bir sual sorulduğunda çoğunlukla hata yaparlar. 2024 senesinde ChatGPT benzer biçimde modellere “strawberry” kelimesinde kaç tane r harfi bulunduğunu sormak popüler bir benchmark haline gelmişti ve en iyi modeller dahi hata yapıyordu.

2 milyar ile 7 milyar arasındaki fark nedir?

Eğitim verisi, bağlam uzunluğu (context length) ve tokenizer açısından iki model de birebir aynı spesifikasyonlara haiz. Tek fark modellerin boyutları. Dil modellerinin kabiliyetleri ve hafızaları, haiz oldukları parametre sayısıyla paralellik gösterdiği için büyük model daha fazlaca biliyor ve daha hünerli diyebiliriz.

Model, daha evvel eğitilmiş bir Mistral ya da LLaMA üstüne ince ayar yapılarak mı elde edildi?

Hayır! Model mimarisinin Mistral olması, önden eğitilmiş (pre-trained) bir Mistral modelinin alınıp eğitilmeye devam edilmiş olduğu (continual pre-training) ya da ince ayar (fine-tuning) yapıldığı anlamına gelmiyor. Kumru, tokenizer’ı ve model weight’leri ile uçtan uca tamamen sıfırdan yaratıldı ve eğitildi.

LLaMA benzer biçimde bir modeli continual pre-training yapmak yerine niçin sıfırdan eğittiniz?

Continual pre-training oldukça makul bir strateji ve Türkiye’deki pek fazlaca grup da bunu yapıyor. Sadece dezavantajı, orijinal modelin tokenizer’ının kullanılmasını gerektirmesi. Bu da hem eğitim esnasında, hem de kullanım esnasında metinler işlenirken, Türkçe bir tokenizer’a nazaran daha çok token harcanması ile sonuçlanıyor. Netice olarak modeli eğitme ve kullanma maliyeti ve süresi 2 katına kadar artıyor.

Pre-trained bir modelin embedding matrix’ini ve tokenizer’ını ameliyat edip Türkçe’ye uyarlamak mümkün, fakat bu da yalnızca bir yere kadar etkili, ve model ile tokenizer arasındaki bağları koparmış oluyorsunuz. Biz bunun yerine Türkçe’nin gereksinimlerini da göz önünde bulundurarak pretokenization regex’i, kod ve matematik desteği de olan ve tüm dizayn kararlarını bilgili bir halde verdiğimiz çağıl bir Türkçe LLM tokenizer’ı geliştirmeyi ve Kumru’yu bununla eğitmeyi seçtik. Tüm bu adımları baştan sona yapmanın getirmiş olduğu tecrübeye bağlı data birikimi de cabası.

Mimari olarak niçin LLaMA, Gemma, QWen benzer biçimde alternatifler varken niçin Mistral seçtiniz?

Projeye 2024 ortasında başladığımız zamanlarda açık-kaynak modellerde LLaMA ve Mistral başı çekiyordu. Bilhassa Mistral, sliding window teknolojisi ile başlangıçta bilhassa uzun bağlama haiz metinleri işler ve üretirken fazlaca başarı göstermiş görünüyordu. LLaMA modeli ise yayınladığı detaylı teknik raporlarla bir büyük dil modelinin uçtan uca iyi mi eğitildiği mevzusuna ışık tutuyordu. Mistral modeli, v0.3 ile sliding window teknolojisini artık kullanmamaya karar verdi şundan dolayı uzun bağlamlarda hatalara sebep olduğu fark edildi. Bu fark ortadan kalkınca Mistral v0.3 ile LLaMA-3 mimarileri birebir aynı hale geldi. Dolayısıyla Mistral seçimimiz bu iki modelin başarısına, birbirlerinin tıpatıp aynısı olmalarına ve geliştirme sürecine ışık tutan LLaMA-3 teknik makalesine dayanıyor.

Hangi verileri kullandınız?

İçerikleri Mart 2024 evveliyatına dek üretilmiş Türkçe web derlem başta olmak suretiyle wikipedia, haber metinleri benzer biçimde literatürdeki veriler ile %5 oranında da İngilizce web ve kod derlemlerini kullandık.

Geliştirme haritanız iyi mi?

İlk hedefimiz modelin yapmış olduğu hataları en aza indirmek için pekiştirmeli öğrenme aşamasından geçirmek. Paralelde görselleri ve taratılmış dökümanları işleme kabiliyeti kazandırarak Kumru’yu multimodal bir model haline getirmek için bir image encoder entegrasyonunu çalışıyoruz. Bunun yanında Kumru’nun daha büyük ve maharetli versiyonlarını da daha büyük ve güncel verisetleri ile eğitmeyi planlıyoruz.

Şu anda OpenAI’ın 2022 başlangıcında duyurduğu davinci-001 modeli ile aynı aşamadayız. O yüzden OpenAI’ın GPT modellerinin ayak izlerini takip ederek ilerliyoruz diyebiliriz.

7 milyarlık modeli de açık kaynak yayınlayacak mısınız?

Daha büyük ve multimodal modeller ürettikçe 7 milyarlık versiyondan başlayarak eski modelleri yayınlamayı planlıyoruz.

Kumru ile ilgili detaylı data için: