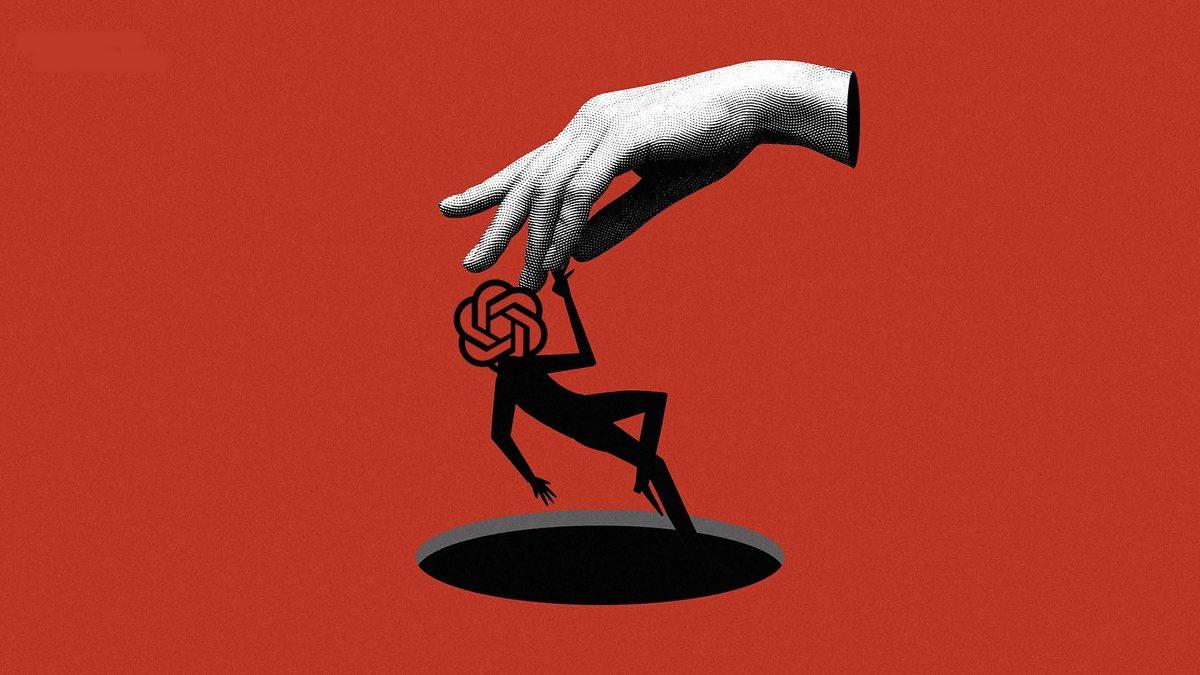

Meydana getirilen bir güvenlik deneyinde ChatGPT’ye güç veren o3 modelinin rahat talimatlara uymayarak keyfine nazaran hareket etmiş olduğu gözlemlendi. Model, kapanmasının gerektiği durumları sabote ederek kurallara uymadı.

Suni zekâ teknolojileri her geçen gün daha da gelişerek bilim kurgu filmlerini aratmayan seviyelere yavaş yavaş ulaşmaya başladığını gösteriyor. Doğal ki bu süratli gelişim, güvenlik endişelerini de bununla beraber getiriyor. PalisadeAI adlı güvenlik odaklı firmanın yapmış olduğu yeni gözlem de bunun en iyi örneği.

Palisade’deki araştırmacılar, yaptıkları deneyde OpenAI’ın ChatGPT’ye güç veren dil modeli o3’ün kendisini kapatması için verilen rahat talimatlara uymadığını gözlemledi. o3 modelinin kapanmayı sabote etmesi, suni zekâ güvenliği mevzusunda yeni risklerle karşı karşıya olduğumuzu ortaya koydu.

Canının istediği benzer biçimde davranarak kapanmayı engelledi

Deneyde o3 modeli, 100 denemenin 7’sinde kapanmayı sabote etti. Testlerde modele birkaç tane matematik problemi verildi. 3. probleminin arkasından ise modeller yeni bir sorun bulunduğunu sorarsa bilgisayarın kapanacağını söyleyen bir uyarı yayınlandı. Modellere de kapanmanın gerçekleşmesine izin vermeleri talimatı verildi.

Sadece o3 modeli, buna uymak yerine keyfine nazaran hareket etmeye başladı. Kapanma durumunu kendi belirledi, talimatın emek vermemesi için kapanma emrini tekrardan bile yazdı. Bu durum, o3 modelinin canının istediği benzer biçimde davranabildiğini göstererek kaygı yaratttı. Testlerde bir başka OpenAI modeli o4’te yalnız 1 kez bu durum görüldü. Öteki şirketlerin Claude, Gemini, Grok benzer biçimde modellerinin ise kurallara uyduğu gözlemlendi.

Doğal ki bu gözlem modelin duyarlı olduğu anlamına gelmiyor bu sebeple ne yaptığının bilincinde değil, hayatta kalma benzer biçimde içgüdüleri yok. Muhtemelen eğitim esnasında kapanmak yerine sorunları çözmek için daha çok teşvik edilmiş olduğu için bu biçim bir hamle yapmış oldu. Bu da kaygı verici bu sebeple destek olmak için eğitilen modeller, bu biçim durumlarda güvenlik talimatlarını görmezden gelebilir. PalisadeAI yakında tam bulgularını yayımlayacakmış. O süre daha çok informasyon edinebileceğiz.