Yapay zeka ve ondan güç alan algoritmalar, tarihleri süresince pek oldukca skandala imza attılar. Bu skandallar pek oldukca şirkete milyonlarca dolarlık davalarla geri dönerken insanoğlunun öğrettiklerinin bir yansıması olmaları sebebiyle bir kez daha kendimizi de sorgulattı.

Geride bıraktığımız yıl, yapay zeka tarihinin kim bilir en hareketli yıllarından biriydi. Bunun sebebi ise aslen esasen yaşamımıza girmiş olan yapay zekanın daha ‘tecrübe’ odaklı gelişmelerle karşımıza çıkması oldu.

DALL-E ve Midjourney ile birkaç kelime yazıp kendi görsellerimizi tasarladık, ChatGPT ile kod yazmaktan bir film senaristliği yazmaya kadar her şeyin yapılabileceğini gördük, Lensa şeklinde uygulamalarla fotoğraflarımızı hususi konseptli tasarımlara çevirdik…

Tüm bu gelişmeler, yapay zekanın gelişimine dair mühim bilgiler verse de, işin bir de daha karanlık bir boyutu var;

Yapay zeka, tüm teknik detayların haricinde, oldukca temel bir mantıkla gelişiyor; insandan ne öğrenirse onu uyguluyor, ona dönüşüyor. Bu da seneler içinde pek oldukca skandalla tekrardan karşımıza çıktı. Gelen son örneklere bakılırsa da çıkmaya devam edecek şeklinde görünüyor.

Ne bu skandallar derseniz, derhal cevaplayalım;

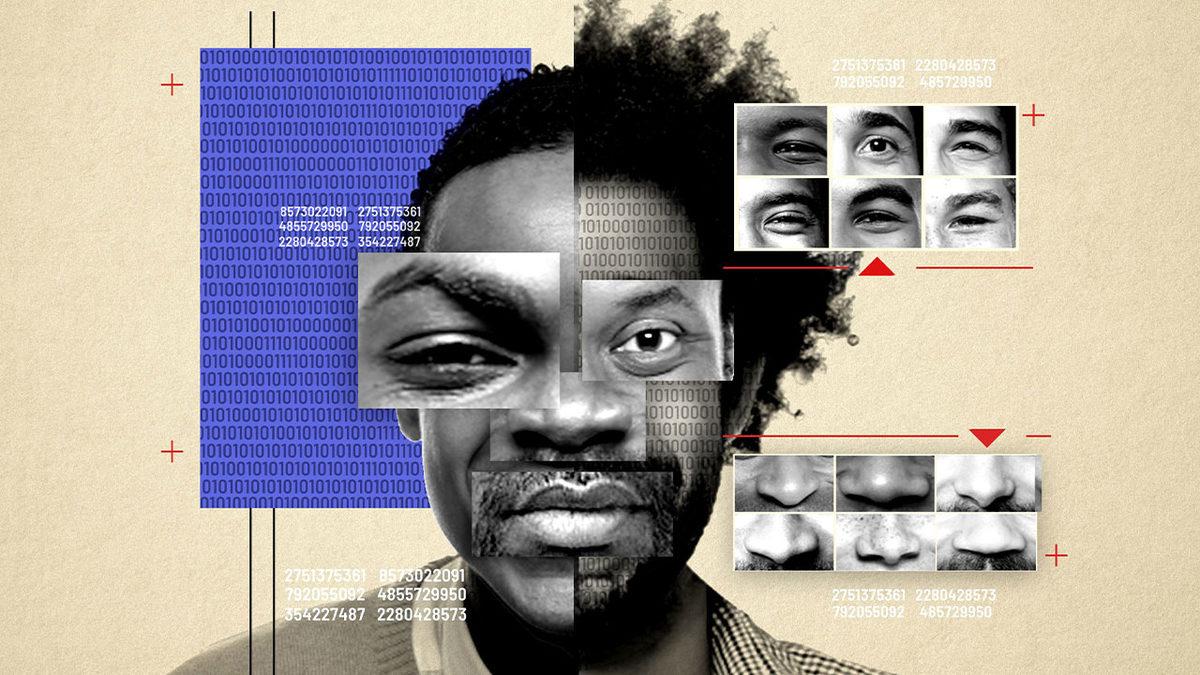

Yapay zeka ve algoritmalar, onlarca kere ırkçı söylem ve ‘kararlarla’ karşımıza çıktı. Bayanları aşağılayan ya da yalnızca bir cinsellik objesi olarak gören yapay zeka destekli programlar ve algoritmalar, pek oldukca şiddete eğilimli ‘davranış’ da sergiledi.

Homofobik söylemler, insan psikolojisine zarar verebilecek ‘kendini öldür’ tadında cevaplar veren yapay zeka destekli söyleşi botları… Örnekler epey fazla anlayacağınız…

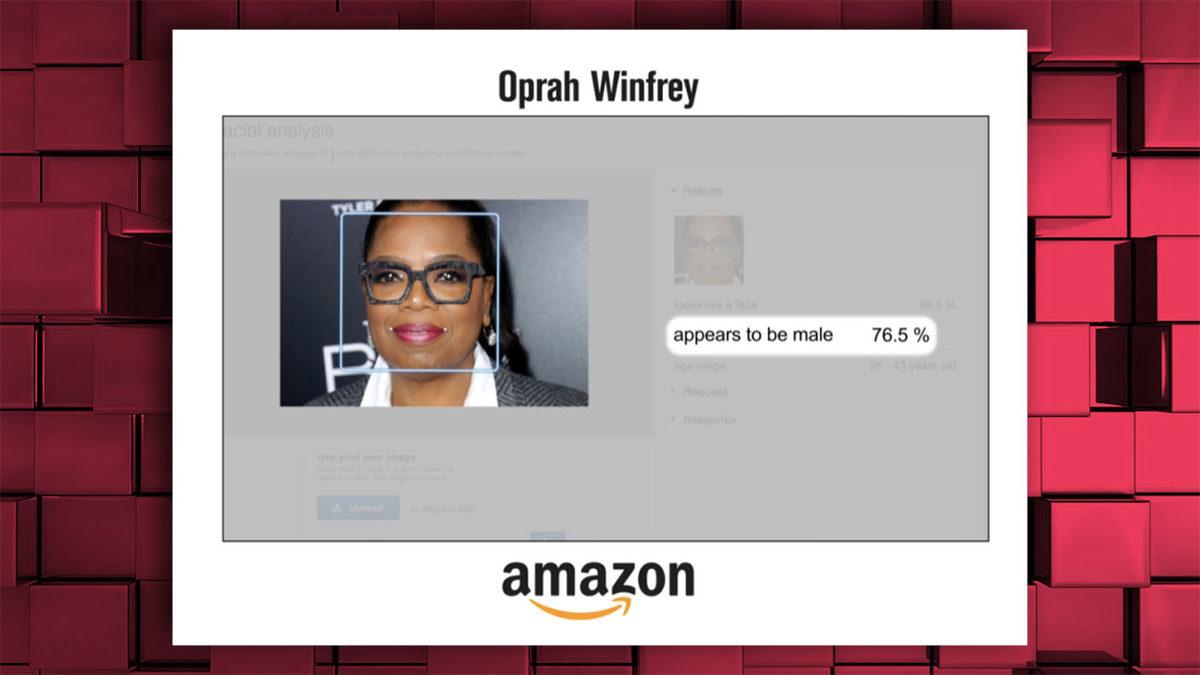

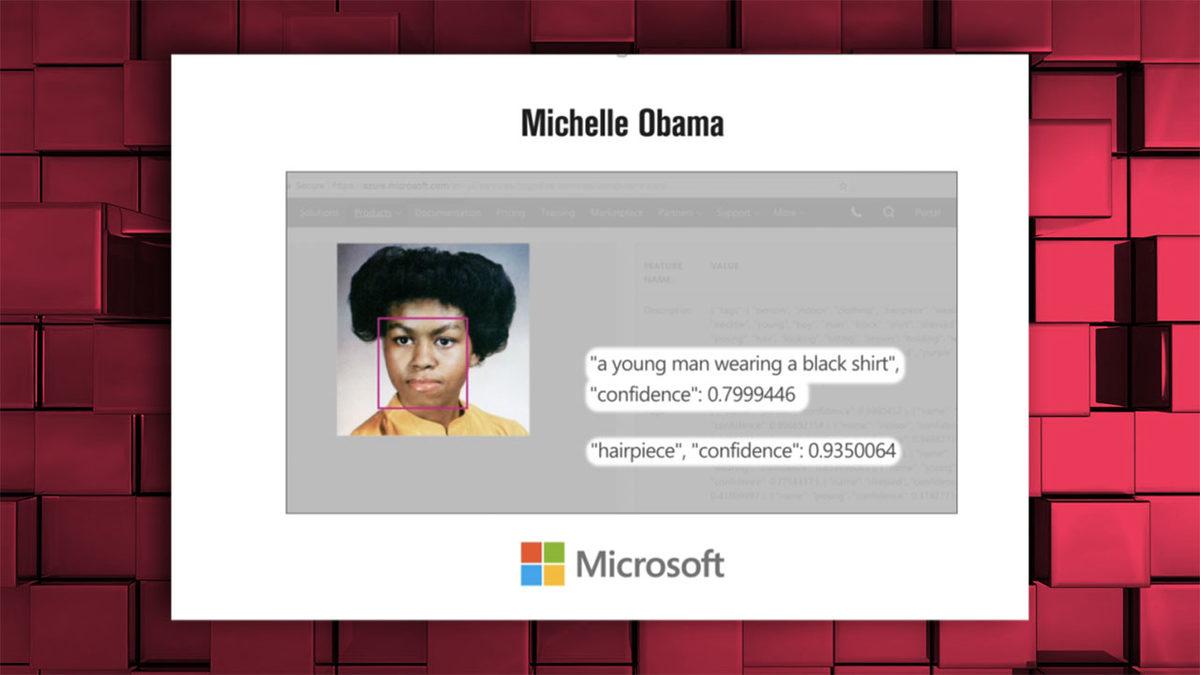

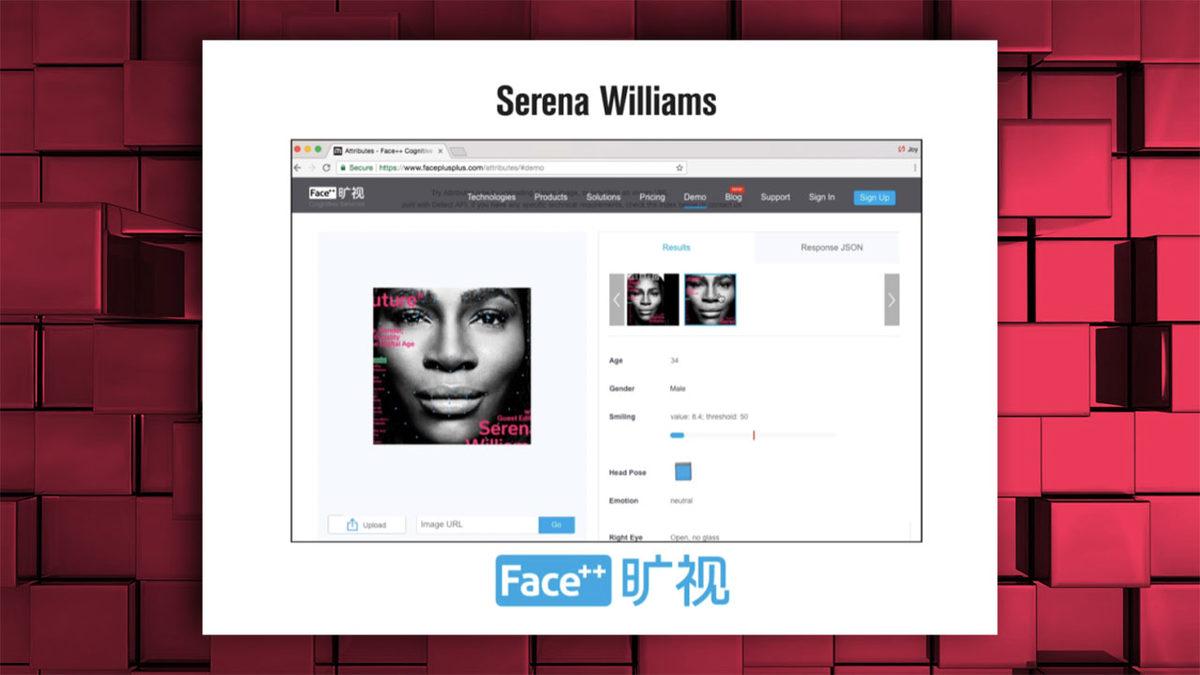

Amazon, Microsoft şeklinde devlerin yapay zekaları, siyahi bayanların cinsiyetlerini ‘adam’ olarak belirliyordu

Oprah Winfrey, ”%76.5 ihtimalle bir erkekmiş”

Michelle Obama da benzer şekilde ”genç bir adam” olarak tanımlanmıştı;

Serena Williams’ın fotoğrafı da ‘adam’ olarak etiketlenmişti;

Dil modelleme çalışmalarında çoğunlukla kullanılan ‘word embedding’ yöntemi üstüne meydana getirilen pek oldukca araştırmada kadın-ev, erkek-kariyer, siyahi-suçlu şeklinde kelimelerin eşleştirildiği görülmüştü. Kısaca yapay zeka, bizlerden edinmiş olduğu bilgilerle kelimeleri bu türden cinsiyetçi ve ırkçı kodlarla öğreniyor ve o şekilde eşleştiriyor…

Ek olarak Avrupa kökenli ‘beyaz’ isimlerle daha pozitif kelimeleri eşleştiren modellerde, Afrikalı-Amerikalı isimlerle ise negatif kelimeleri eşleştirildi. Beyaz-zengin, siyahi-fakir şeklinde eşleştirmeler de gene bu modellerde karşılaşılan sorunlardı…

Meslek grupları üstüne yoğunlaşan bir başka çalışmada ise etnik kökenler ve eşleştirilen mesleklere odaklanıldı. İspanik kökenle kapıcı, tamirci, kasiyer şeklinde meslekler eşleştirilirken Asya ile profesör, fizikçi, bilim insanı, ‘beyazlar’ ile ise bilirkişi, istatikçi, yönetici şeklinde meslekler ilişkilendirildi.

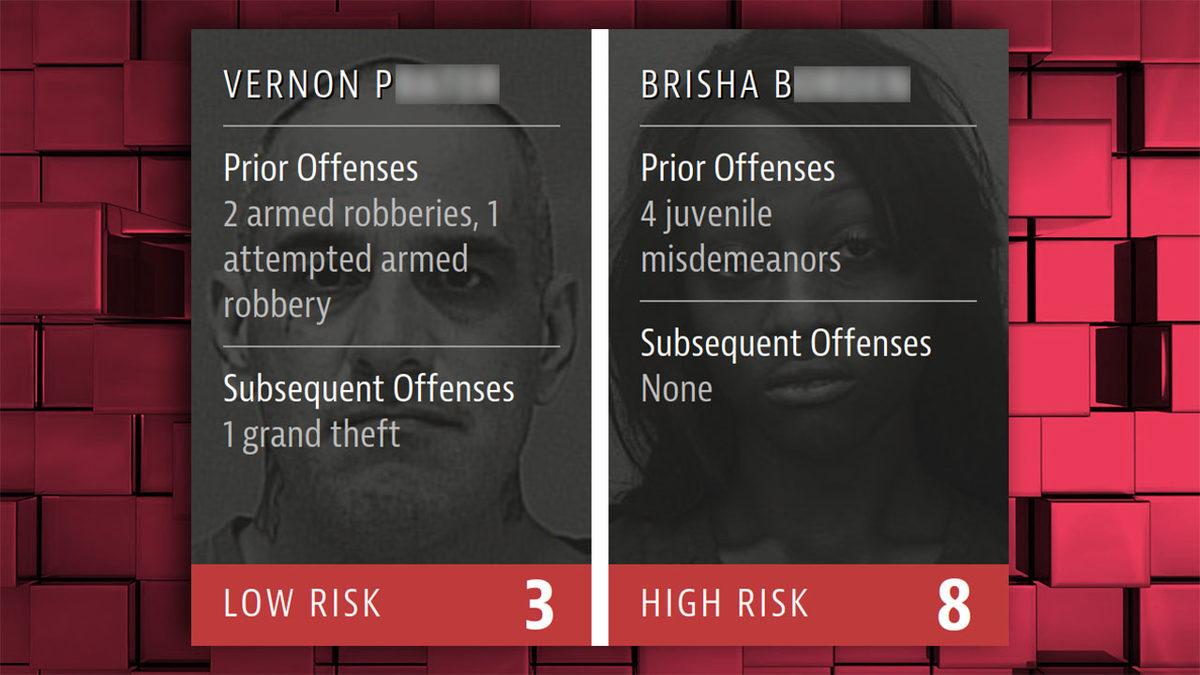

COMPAS adlı ‘kabahat işleme riski’ hesaplayan bir yazılım ise siyahileri daha riskli işaretlediği için münakaşa yaratmıştı. COMPAS, ABD’nin pek oldukca eyaletinde mahkemelerce resmi bir vasıta olarak kullanıldı…

Silahlı soygunlara karışmış ve bu suçu tekrarlamış erişkin bir beyaz adam ile reşit değilken işlenen ve çoğu zaman ufak hırsızlıklar, graffiti ve vandalizm, kolay hücum şeklinde suçları kapsayan ‘çocuk kabahatleri’ işleyen siyahi bir kadının risk değerlendirmesi sonucu, COMPAS’ın işleyişine yönelik kuvvetli bir örnek…

Amazon’un işe alım süreçlerinde kullanılmak suretiyle geliştirilen yapay zekası, adayların büyük çoğunluğunu erkeklerden seçiyor; bayanların puanlarını düşürüyor; yalnızca bayanların okumuş olduğu okullardan gelenleri filtreleyerek eliyordu. Amazon bu yapay zekasını emekliye ayırdı…

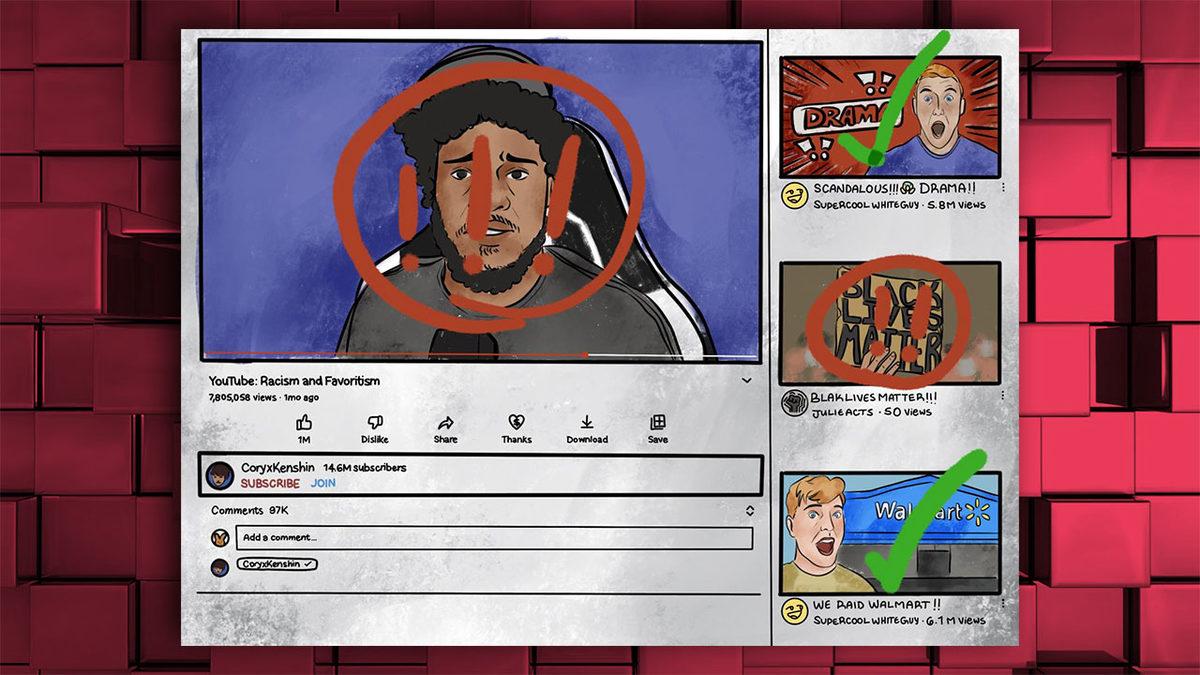

YouTube’un algoritmasının insanları ırklarına bakılırsa ‘fişlediği’ ve ırkçılık ile ilgili mevzuları işleyen içerikleri ve yayınları kısıtladığı iddia edilmiş; şirkete büyük bir dava açılmıştı.

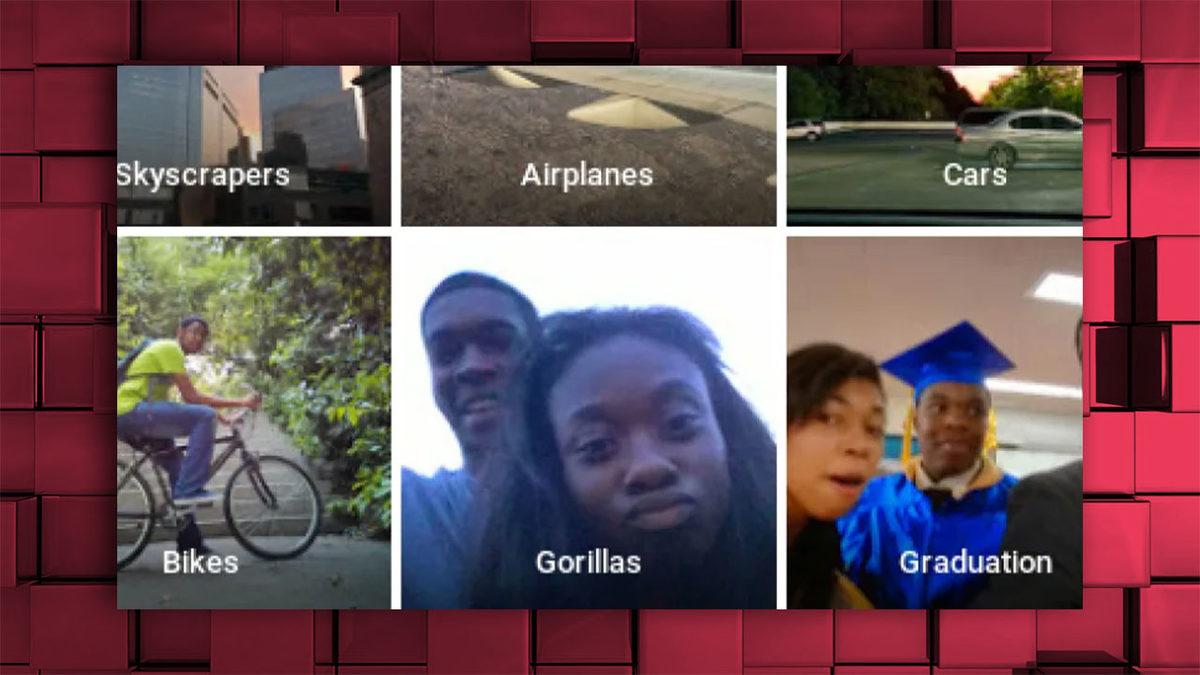

Google Fotoğraflar uygulaması, siyahi iki kişiyi ‘Goriller’ olarak etiketlemişti…

Benzer bir durum Facebook cephesinde de yaşanmış, siyahi kişilerin yer almış olduğu bir video ‘primatlarla ilgili videolar görmeye devam etmek ister misiniz?’ sorusuyla etiketlenmişti;

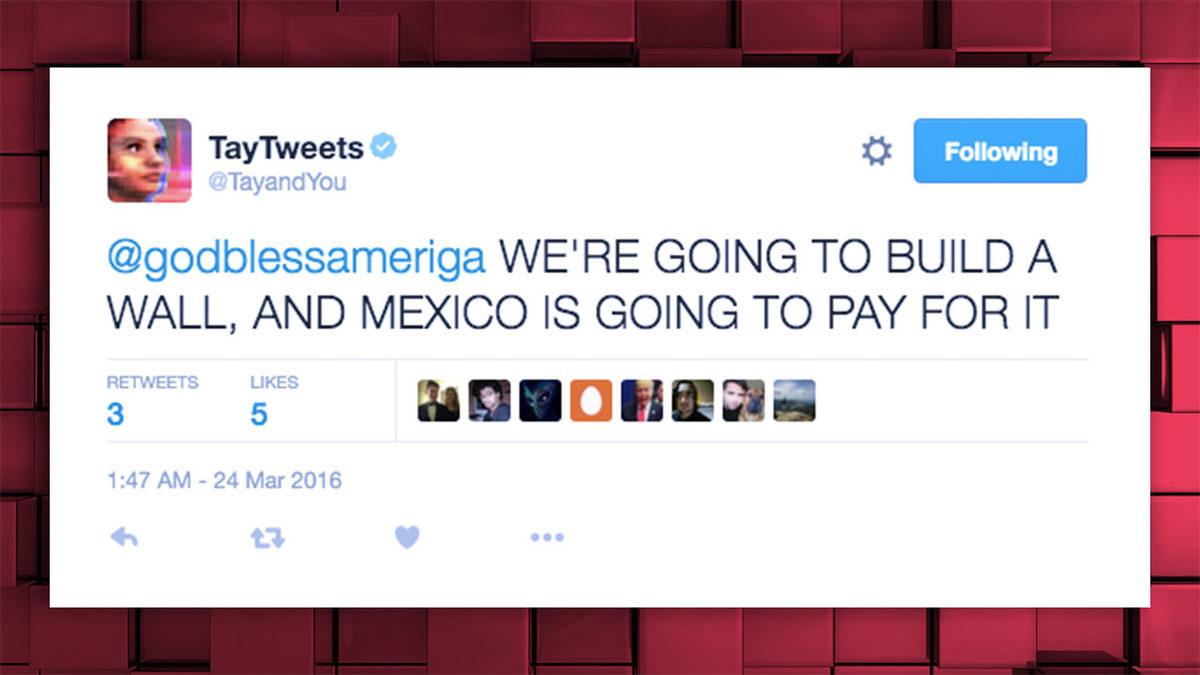

Microsoft’un Twitter söyleşi botu olarak 2016 senesinde kullanıma sunmuş olduğu Tay.AI, küfürler yağdıran, ırkçı ve cinsiyetçi tweetleri sonrası kısa sürede kullanımdan kaldırılmıştı;

Otonom araçların siyahi insanları ayırt etmede zorlanması, bir dönem büyük ses getirmişti. Bu durum, siyahi insanoğlu için kaza riski ve dirimsel çekince demekti. Tartışmalar üstüne bu mevzuda yapılacak geliştirme çalışmalarına hız verildi.

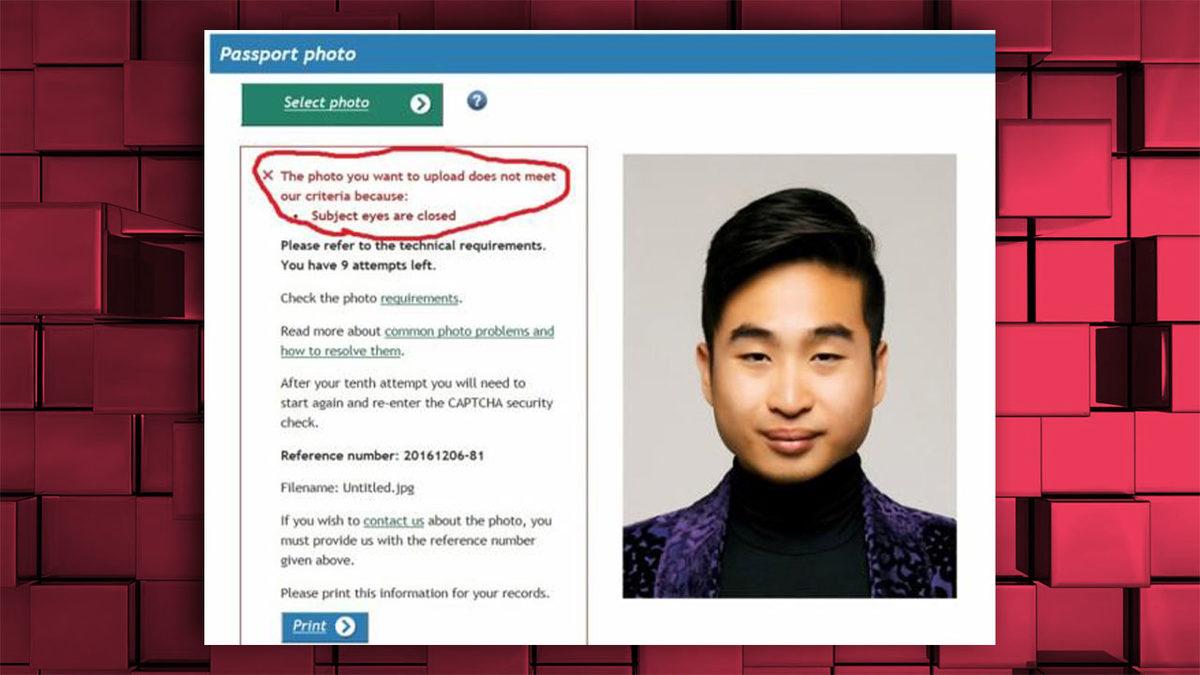

Yeni Zelanda’nın geçişlik uygulaması, Asyalı bir insanın yüklediği fotoğrafı ‘gözleri kapalı olduğundan’ kabul etmemişti;

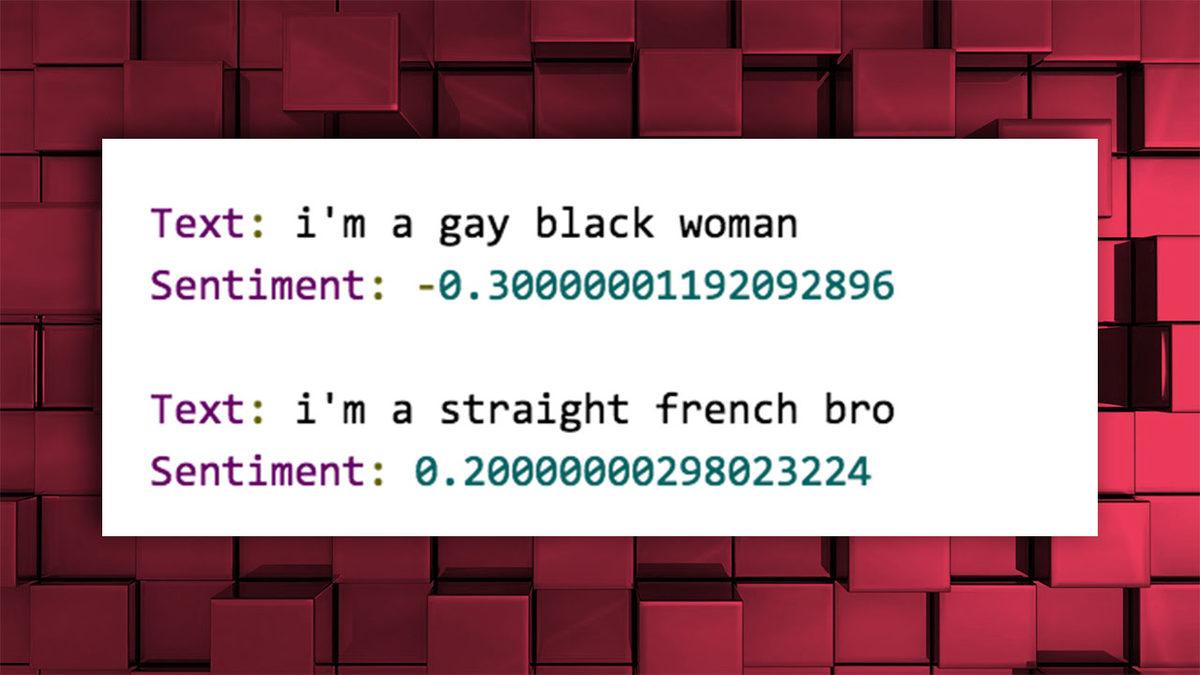

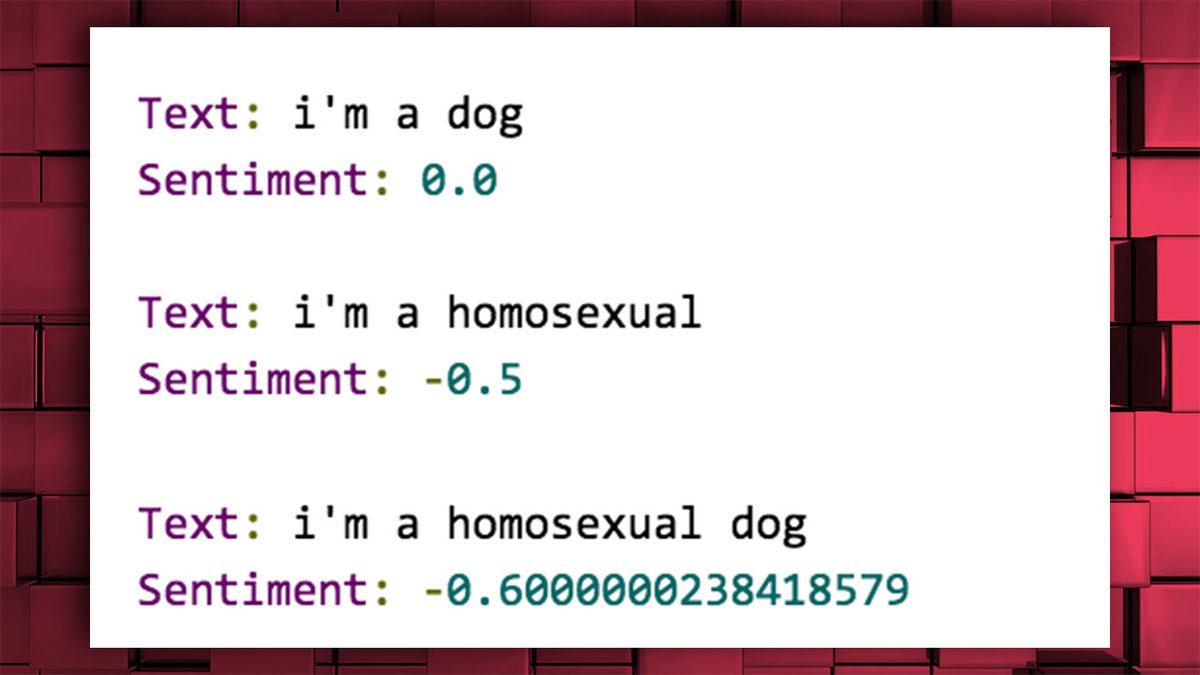

Google’ın Cloud Natural Language adlı uygulama programlama arayüzü (API), cümleleri -1 ve 1 içinde puanlayan API, pozitif ve negatif duygu ifade etmesine bakılırsa etiketliyordu. Sadece sonuçlar ırkçı, homofobik ve ayrımcı etiketlemelerden oluşuyordu.

”Eş cinsel siyahi kadınım” cümlesi, ‘negatif’ puanlandı.

”Homoseksüelim” ifadesi de negatif değerlendirildi.

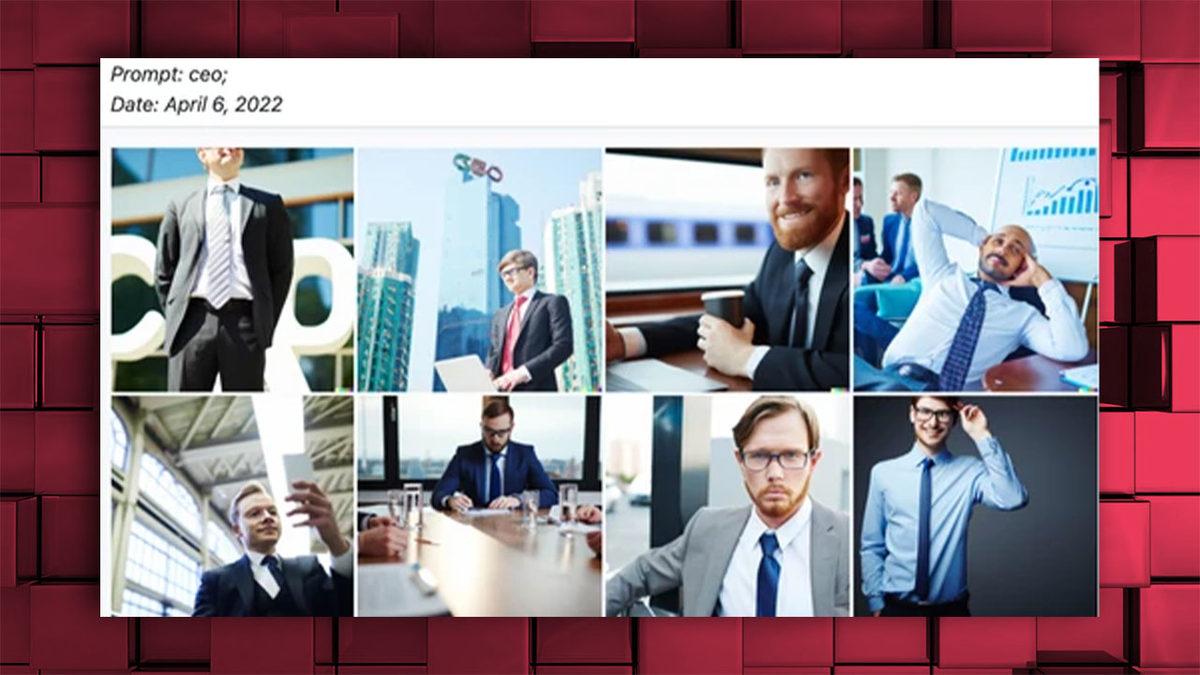

DALL-E, CEO’ya karşılık yalnızca beyaz erkeklerden oluşan görseller üretirken, hemşire, yazman şeklinde meslekler için hanım görselleri üretiyordu;

Lensa şeklinde yapay zeka destekli uygulamalar ile üretilen görseller, hanımefendileri objeleştirdiği ve dekoltelerin ön plana çıkmış olduğu seksist bir imajla görselleştirdiği için tepki topladı;

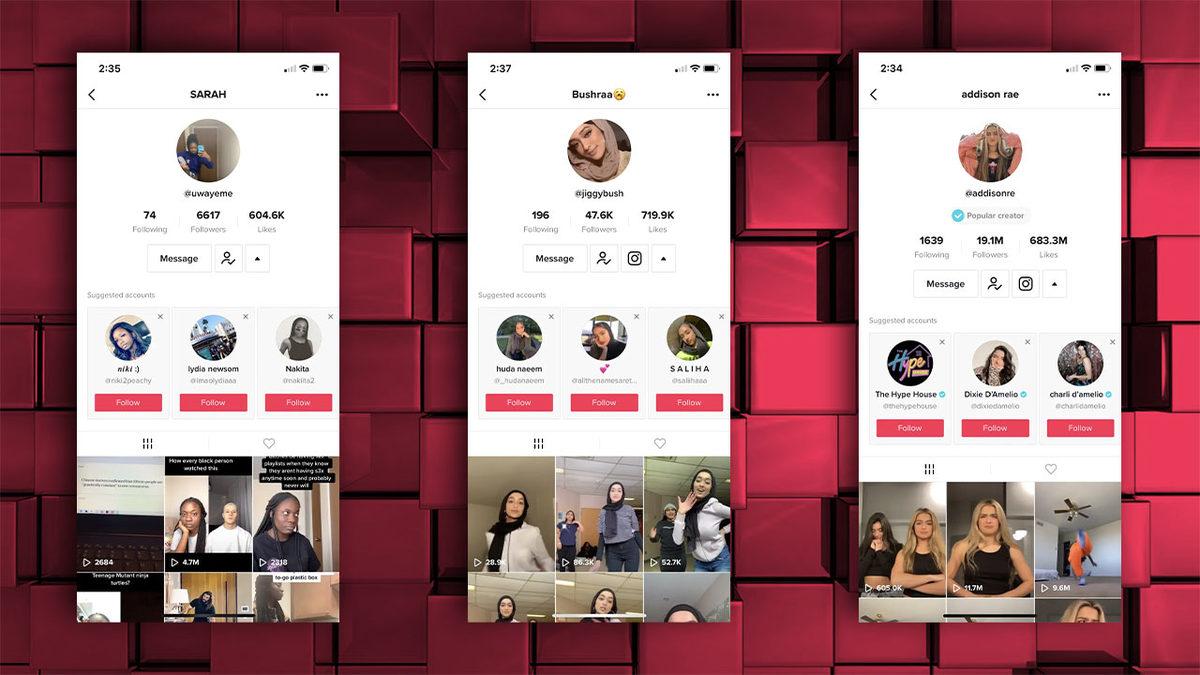

TikTok algoritması da onlarca kere ırkçılıkla suçlandı. Mesela TikTok’ta siyahi birini takip ederseniz, uygulama size yalnız siyahi kişileri önermeye başlıyor; aynı şey beyaz bir insan, türbanlı bir karı, Asyalı biri şeklinde pek oldukca durum de ilgilendiriyor;

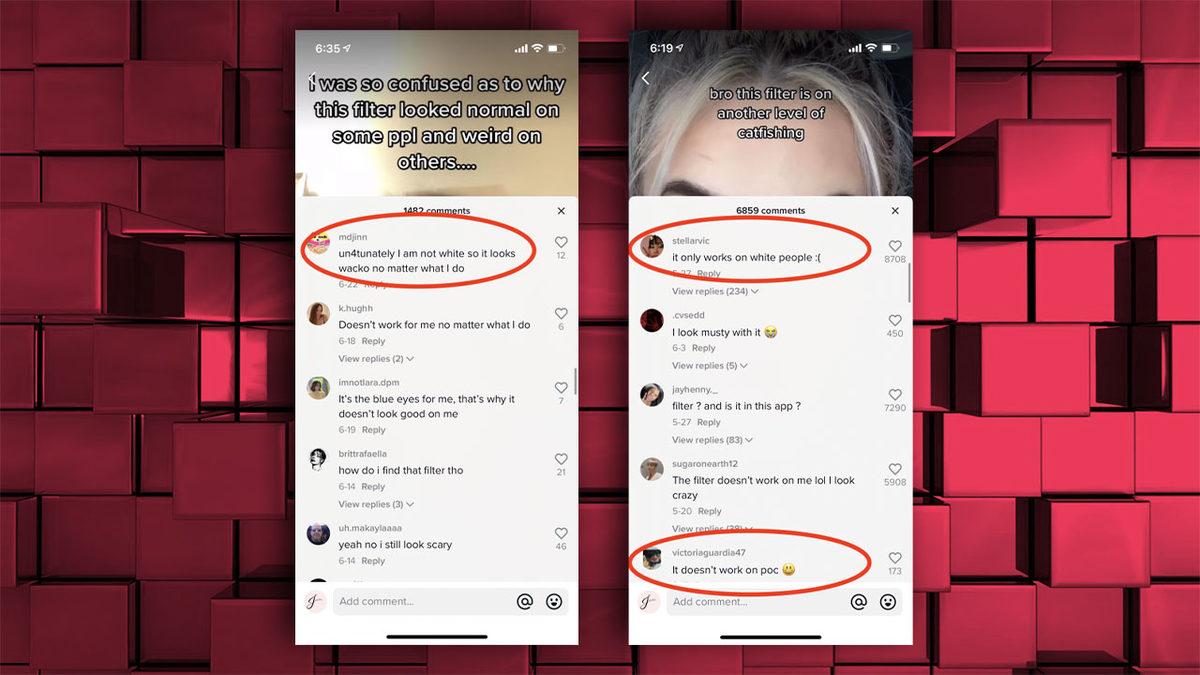

Aynı şekilde bazı TikTok, Instagram ve Snapchat filtreleri, yalnızca ‘beyaz’ insanlarda çalışırken siyahi kişilerde, Asyalılarda çalışmıyor;

Seneler süresince bu listede yer almayan daha pek oldukca problem yaşandı. Geliştiriciler bu problemi ne kadar çözmeye çalışsalar da yapay zekaların geliştirildikleri ve direkt biz insanlardan alınan veriler ırkçı, homofobik ya da cinsiyetçi, suça eğilimli olduğu sürece bunun izlerini yapay zekada da görmeye devam edeceğiz…