Görünüşe nazaran yapay zekâların fotoğraf tanıma sistemini kandırmak oldukça kolay. Peki, bundan iyi mi kaçınılabilir?

Yapay zekâlar öğrenme enerjisini, verilerindeki şemaları tanımlamasına yarayan kabiliyetinden alır. Bir sinir ağına on binlerce sınıflandırılmış hayvan fotoğrafları yüklerseniz, yapay zekâ onun panda mı yada maymun mu bulunduğunu idrak etmek için belirli şemaları öğrenir. Bu şemalarla da daha ilkin asla görmediği bir hayvanı tanımlayabiliyor.

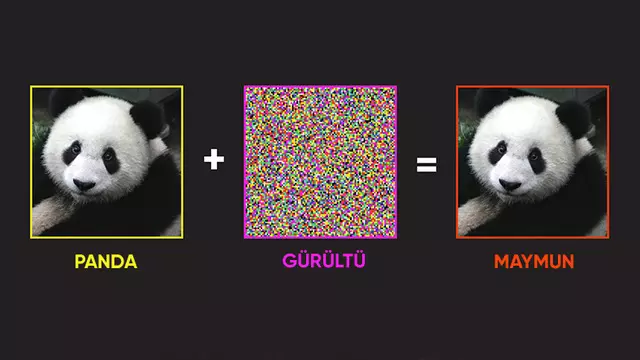

Sadece yapay zekâlardaki öğrenme gücü şu an için birazcık kırılgan. Fotoğraf tanımlama sistemi, daha derin bir ‘gördüğünü anlama’ sistemi yerine px şemalarını kullandığı için resimde küçücük oynamalar yaparak sistemi kandırmak oldukca kolay bir hale geliyor. Örnek verecek olursak bir panda fotoğrafına birazcık gürültü eklerseniz sistem onu maymun olarak tanımlayabiliyor ve bundan %100 güvenli bulunduğunu belirtiyor.

Geçtiğimiz hafta yapay zekâ araştırma konferansı ICLR’da sunulan bir belgede, siber saldırıların kaçınılamaz olduğu söyleniyordu. Yanlış sınıflandırmayı tetikleyen rastgele gürültüler, aslen görüntü sisteminin belirli nesnelerle kuvvetli bir halde ilişkilendirmeyi öğrendiğini gösteriyor. Bir başka deyişle, bizim panda gördüğümüz yerde sistem maymun görmüş olduğu süre aslen yanlış bir davranış sergilememiş oluyor.

Araştırmacılar iki tür bağıntı bulunduğunu keşfetti: Bir kedi görüntüsündeki bıyıklar yada panda görüntüsündeki kürk renkleri şeklinde verinin manasıyla bağıntı kuran şemalar ve bir tek yapay zekânın tahsil sürecinde ona verilen veriler. Bu ikinci bağıntı şu an için daha yaygın durumda. Yapay zekânın öğreniminin zayıf olması sebebiyle içine sızmak kolaylaşıyor.

Bu da bizlere eğer siber hücum riskini azaltmak istiyorsak, yapay zekâ eğitim modelini değiştirmemiz icap ettiğini gösteriyor. Şu an için, resimlerdeki objeleri tanımlamak için sinir ağının lüzumlu bağıntıları seçmesine izin veriliyor. Sadece bunun sonucunda kurulan bağıntılar üstünde denetim elde edilemiyor. Bunun yerine yapay zekâları bir tek gerçek nesneleri bağdaştırması için kendimiz eğitirsek, zarar görme olasılığı düşebilir.

Araştırmacılar bu yöntemi denediklerinde, sistemin yalnızca %50 oranında yanıltılabildiğini gördüler, diğer türlü bu oran %95’te idi. Başka bir deyişle, siber saldırılar kaçınılmaz durumda sadece onları olabildiğince azaltmak için elimizden geleni yapmalıyız, zira yavaş yavaş yapay zekâ devrimine doğru yaklaşıyoruz.